- 防止个人身份信息(PII)泄露

- 检测并阻止提示词注入攻击

- 拦截不当或有害内容

- 执行业务规则与合规要求

- 验证输出质量与准确性

确定性防护栏

使用基于规则的逻辑,例如正则表达式模式、关键词匹配或显式检查。快速、可预测且成本效益高,但可能遗漏细微的违规行为。

基于模型的防护栏

使用LLM或分类器通过语义理解来评估内容。能捕捉规则可能遗漏的细微问题,但速度较慢且成本更高。

内置防护栏

PII 检测

LangChain 提供了内置中间件,用于在对话中检测和处理个人身份信息(PII)。该中间件可以检测常见的 PII 类型,如电子邮件、信用卡号、IP 地址等。 PII 检测中间件适用于以下场景:需要满足合规要求的医疗保健和金融应用、需要清理日志的客户服务智能体,以及任何处理敏感用户数据的应用。 PII 中间件支持多种策略来处理检测到的 PII:| 策略 | 描述 | 示例 |

|---|---|---|

redact | 替换为 [REDACTED_TYPE] | [REDACTED_EMAIL] |

mask | 部分遮蔽(例如,显示最后4位数字) | ****-****-****-1234 |

hash | 替换为确定性哈希值 | a8f5f167... |

block | 检测到时抛出异常 | 抛出错误 |

内置 PII 类型和配置

内置 PII 类型和配置

内置 PII 类型:

email- 电子邮件地址credit_card- 信用卡号(通过 Luhn 算法验证)ip- IP 地址mac_address- MAC 地址url- URL

| Parameter | Description | Default |

|---|---|---|

piiType | 要检测的 PII 类型(内置或自定义) | Required |

strategy | 处理检测到的 PII 的方式 ("block", "redact", "mask", "hash") | "redact" |

detector | 自定义检测正则表达式模式 | undefined (使用内置) |

applyToInput | 在模型调用前检查用户消息 | true |

applyToOutput | 在模型调用后检查 AI 消息 | false |

applyToToolResults | 在执行后检查工具结果消息 | false |

人工介入循环

LangChain 提供了内置中间件,用于在执行敏感操作前要求人工批准。这是应对高风险决策最有效的防护栏之一。 人工介入循环中间件适用于以下场景:金融交易和转账、删除或修改生产数据、向外部发送通信,以及任何具有重大业务影响的操作。自定义防护栏

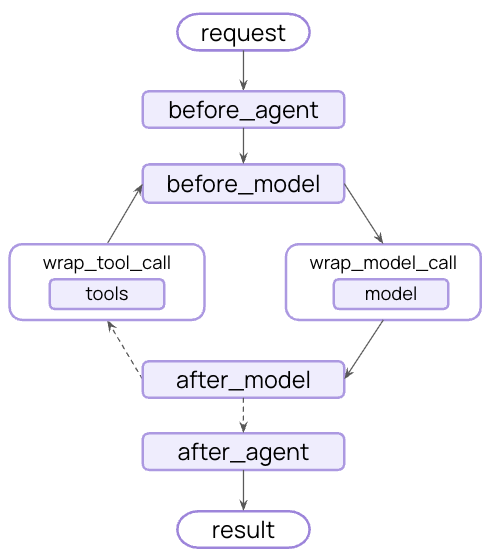

对于更复杂的防护栏,您可以创建在智能体执行前后运行的自定义中间件。这使您能够完全控制验证逻辑、内容过滤和安全检查。智能体执行前防护栏

使用”智能体执行前”钩子在每次调用的开始验证请求。这对于会话级别的检查非常有用,例如身份验证、速率限制,或是在任何处理开始之前阻止不适当的请求。智能体执行后防护栏

使用”智能体执行后”钩子在返回给用户之前验证最终输出。这对于基于模型的安全检查、质量验证,或是对完整智能体响应进行的最终合规性扫描非常有用。组合多个防护栏

您可以通过将多个防护栏添加到中间件数组中来堆叠它们。它们按顺序执行,允许您构建分层保护:其他资源

- 中间件文档 - 自定义中间件的完整指南

- 中间件 API 参考 - 自定义中间件的完整指南

- 人工介入循环 - 为敏感操作添加人工审核

- 测试智能体 - 测试安全机制的策略